Articles récents \ France \ Société Une intelligence artificielle non-sexiste, c’est possible ?

L’intelligence artificielle sera un enjeu de taille dans les années à venir. Malheureusement, elle n’est pas immunisée contre le sexisme. Il est important que les utilisatrices/utilisateurs soient conscient·es de la fausse neutralité des algorithmes. Institutions comme entreprises s’engagent déjà pour construire une intelligence artificielle non-sexiste.

Dans les années à venir, le développement de l’intelligence artificielle (IA) à grande échelle est inévitable. Voitures autonomes, détection de cancers, logiciels d’aide à la décision juridique, prévision du trafic autoroutier, recrutement… L’IA est, et sera, un enjeu économique et social de taille, mais ce sera également un enjeu égalitaire et éthique. En effet, caisse de résonance de notre société inégalitaire, l’IA n’est ni neutre, ni objective. Elle est le reflet des stéréotypes et des croyances des personnes qui la construisent.

Alors que les femmes ont historiquement été des pionnières dans le domaine informatique, l’IA est un domaine fortement masculinisé à l’heure actuelle. Selon une étude du Forum économique mondial, seulement 22% des professionnel·les travaillant sur l’IA sont des femmes.

Le manque de mixité dans le domaine de l’IA a une conséquence concrète : la construction d’algorithmes sexistes. Par exemple, en 2015, Amazon se rend compte que son logiciel de recrutement, chargé de traiter les CV pour les postes d’ingénieur·es et de développeuses/développeurs, pénalise les CV contenant le mot “femme” et ses dérivés. Exit, donc, les CV des capitaines des équipes féminines de rugby ou des titulaires d’un diplôme d’une université pour femmes. Dans ces conditions, pas étonnant que les équipes dédiées au développement de l’IA restent majoritairement masculines. Amazon a modifié le logiciel en question mais le problème subsiste.

En l’état, il reste deux possibilités : laisser les inégalités actuelles s’automatiser dans l’IA ou s’engager pour une IA éthique, utilisée pour construire une société plus inclusive. En d’autres termes, ce tournant majeur se fera-t-il avec ou sans les femmes ?

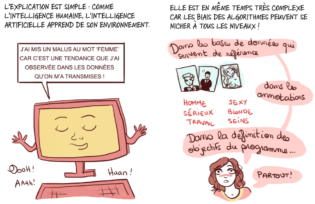

Par quel mécanisme l’IA devient-elle sexiste ?

Le sexisme s’immisce à chaque étape de construction d’un algorithme via ce qu’on appelle la contagion sexiste.

Première étape : la définition de l’objectif de l’algorithme. Des stéréotypes liés à l’identité, au vécu et aux croyances des développeuses/développeurs peuvent se glisser dans l’algorithme. S’ensuit alors des mauvais choix dans la suite d’opérations à accomplir. C’était le cas du logiciel de recrutement d’Amazon qui favorisait un vocabulaire masculin sur les CV.

Deuxième étape : l’entraînement et l’optimisation de l’algorithme. Pour cette étape, les développeuses/développeurs ont recours à des bases de données. Cependant, ces bases de données sont problématiques. Pour commencer, elles manquent de représentativité, ce qui fausse, par exemple, les systèmes de reconnaissance faciale. Dans un rapport publié en collaboration avec la Commission nationale de l’informatique et des libertés (CNIL), le Défenseur des droits note que ces systèmes ont “des difficultés pour identifier les femmes, les personnes non blanches et davantage encore les femmes de couleur, en produisant un taux d’erreur significatif pour ces populations : le stock de données sur lesquelles le modèle s’appuyait était marqué par une très forte prédominance des visages masculins et blancs”.

Par ailleurs, les bases de données sont problématiques car empreintes des discriminations systémiques à l’œuvre dans nos sociétés. Par exemple, en France, les femmes occupent des postes à rémunération moindre et avec moins de responsabilités que les hommes. L’algorithme d’un logiciel de recrutement pourrait en déduire que les femmes sont moins productives et moins adaptées aux postes à responsabilité. Les bases de données qui servent à entraîner les algorithmes sont donc biaisées et entraînent la généralisation erronée d’une population.

Illustration issue de l’adaptation en bande dessinée du livre L’intelligence artificielle, pas sans elles !

Troisième étape : l’évaluation de l’algorithme. On peut citer l’exemple de Compass, un logiciel d’aide à la décision du juge aux Etats-Unis. Son objectif ? Prévoir si les condamné·es vont récidiver sur la base de données statistiques. Un étude publiée en 2016 a prouvé que le logiciel présente deux fois plus de faux positifs pour les personnes afro-américaines que pour les personnes blanches. Or, ce logiciel est un appui pour décider de la remise en liberté conditionnelle des condamné·es. Un risque élevé de récidive retarde la remise en liberté, accroît la désocialisation et renforce in fine le risque de récidive. On se trouve face à une prophétie auto-réalisatrice. Comment déterminer si les prévisions de ce logiciel sont équitables ? La définition de l’équité est forcément subjective et entraîne donc des choix discriminants de la part de l’algorithme.

L’essor récent des IA ayant recours à l’apprentissage automatique (machine learning), c’est-à-dire sur la base de données statistiques, comporte un réel risque d’amplification et d’automatisation des inégalités et discriminations, sous couvert de fausse neutralité. Selon la formule de la mathématicienne Cathy O’Neil, il s’agit d’une “bombe à retardement” pour l’égalité.

L’IA peut-elle devenir un levier d’égalité ?

Le premier pas vers une IA égalitaire et éthique est de former les développeuses/développeurs aux questions d’égalité et de diversité. Il s’agit ensuite d’encoder l’égalité dans les algorithmes. On peut citer l’exemple de Jessica Wade qui a conçu le logiciel Quicksilver qui crée automatiquement des pages Wikipédia sur les grandes femmes de l’histoire. Une belle initiative, surtout quand on sait que sur Wikipédia, 84 à 90% des contributrices/contributeurs sont des hommes et 82% des pages concernent des hommes. Laura Gomez, quant à elle, fondatrice de la start-up Atipica, a développé une IA qui permet aux entreprises de rendre leur processus de recrutement plus inclusif.

Les initiatives institutionnelles se multiplient également pour que les algorithmes respectent des conditions d’égalité et d’explicabilité.

Le droit applicable en France : Le RGPD apporte des premières réponses substantielles à ces défis. Par exemple, au titre de la transparence, il impose, à son article 13, l’obligation de fournir « des informations utiles concernant la logique sous-jacente » de toute décision automatique entraînant un effet important sur la personne. En outre, le CRPA (Code des relations entre le public et l’administration), complété par la loi République Numérique de 2018, précise les informations à fournir à la personne destinataire de la décision individuelle concernant le « degré et le mode de contribution du traitement algorithmique à la prise de décision », « les données traitées et leurs sources », et « les paramètres du traitement et […] pondération appliqués à l’intéressé ». Algorithmes : prévenir l’automatisation des discriminations. Rapport du Défenseur des droits, en partenariat avec la CNIL.

Cependant, de nombreuses questions se posent quant à l’applicabilité de telles dispositions juridiques aux boîtes noires que sont les algorithmes. Comment déterminer si un algorithme est discriminatoire si les personnes qui l’ont conçu n’en n’ont pas conscience ? Peut-on réellement demander réparation quand on ne sait même pas qu’on a été discriminé·e par un algorithme ? Qui sanctionner et comment sanctionner la discrimination exercée par un algorithme ?

L’autre stratégie est de compter sur le droit mou (soft law) pour pousser les entreprises à s’engager à construire des IA équitables. Cela passe par la mise en place de chartes éthiques et la généralisation d’audits à toutes les étapes de construction des algorithmes, des audits qui conditionnent la délivrance de labels. On peut citer le Pacte pour une intelligence artificielle égalitaire entre les femmes et les hommes du Laboratoire de l’Egalité ou encore la Charte internationale pour une IA inclusive par Arborus. Il s’agit d’un ensemble de recommandations à destination des entreprises publiques et privées. Il existe aussi un serment d’hippocrate pour data scientist.

Le secteur privé s’est également emparé de la question pour proposer, en plus des labels et des chartes, des boîtes d’outils techniques pour les entreprises. C’est le cas par exemple du Cercle InterElles avec le Pacte “Femmes et IA”, dont l’objectif est d’aider les entreprises à être pionnières dans la production et l’utilisation d’une IA non-discriminante.

La mise en place du Pacte s’effectue en quatre étapes :

- la signature de la charte,

- l’évaluation avec une grille de critères,

- l’action avec une boîte à outils,

- l’obtention d’un label (lancé courant 2021).

Cependant, rien ne garantit que ces instruments, basés sur le volontarisme, seront suffisants pour assurer l’inclusivité de l’IA.

Ce sujet doit, dès aujourd’hui, être débattu dans l’espace public. Les utilisatrices/utilisateurs doivent être informé·es de la fausse neutralité des algorithmes et, a fortiori, de l’IA pour se mobiliser contre l’automatisation des discriminations.

Maud Charpentier, 50-50 Magazine

Lire plus : Aude Bernheim et Flora Vincent : L’intelligence artificielle, pas sans elles !

Aller plus loin : Podcast du Laboratoire de l’Egalité – L’IA à l’épreuve des stéréotypes

Voir aussi : Le sexisme des algorithmes expliqué par Angèle